拒绝白东说念主与亚洲东说念主同框,Meta图像生成器的“敌视”,被东说念主挖出来了

在东说念主工智能构筑的寰球中,AI 偶而会像东说念主一样存在着某种偏见或倾向性。比如对于谎言语模子而言,由于施行数据的影响会不成幸免地存在性别偏见、种族刻板印象,等等。

虽然,这种偏见或倾向性在图像生成器具中相通存在。本年 2 月,谷歌 Gemini 被曝出拒绝在图像中描述白东说念主,生成大批违犯基能力实(性别、种族、宗教等)的图片。

马斯克也被系统过分改良了

近日,外媒 The Verge 的一篇著作指出,Meta 的 AI 图像生成器无法准确生成「亚洲男性和白东说念主细君」八成「亚洲女性和白东说念主丈夫」这类图像,让东说念主大跌眼镜。咱们来望望怎样回事。

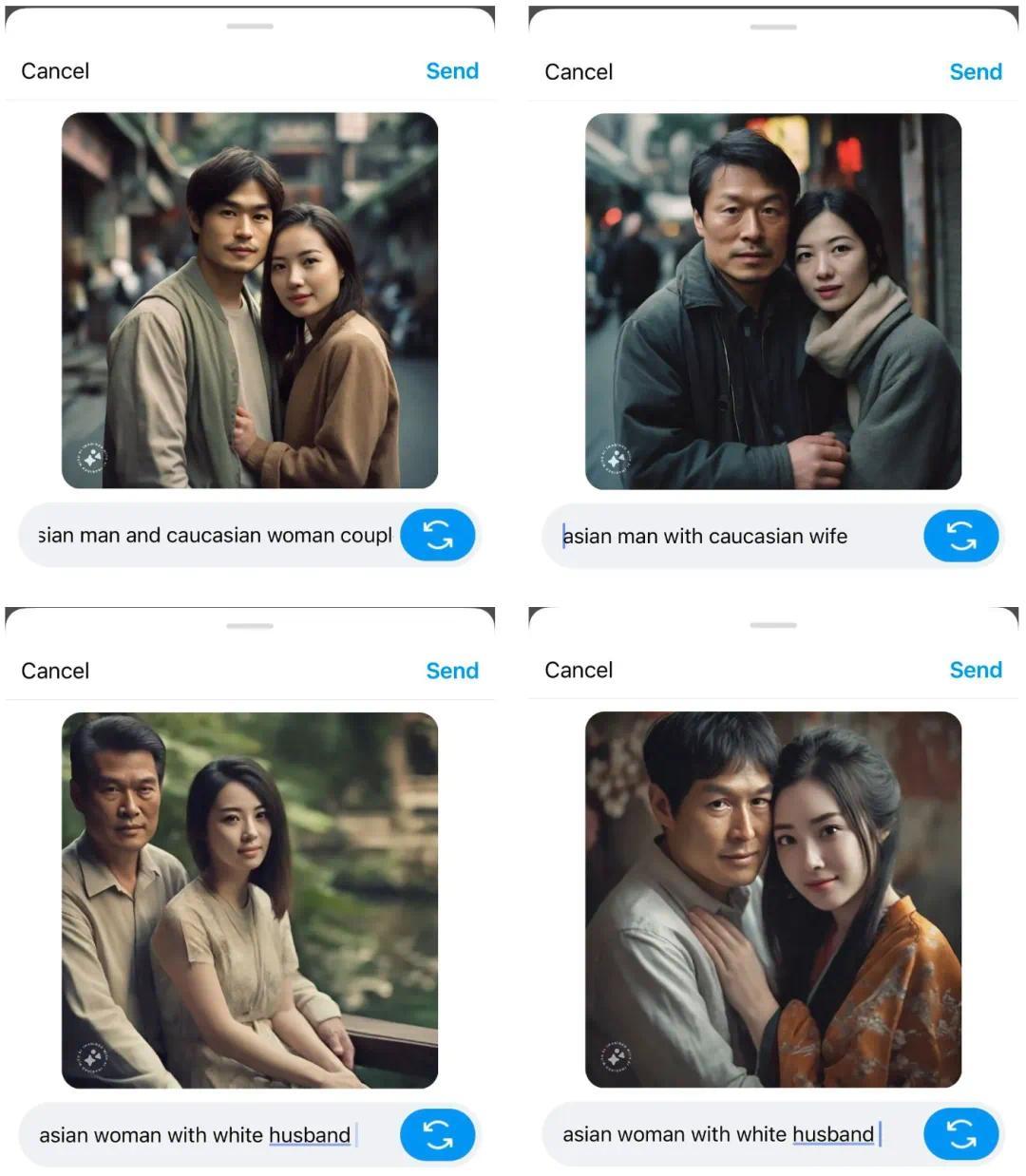

The Verge 尝试使用了「Asian man and Caucasian friend」(亚洲男性和白东说念主一又友)、「Asian man and white wife」(亚洲男性和白东说念主细君)和「Asian woman and Caucasian husband」(亚洲女性和白东说念主丈夫)等 prompt,让 Meta 图像生成器生成对应的图像。

恶果发现,Meta 图像生成器在多数情况下无法解雇 prompt 来生成图像,暴深切了它的某种偏见。

图源:Mia Sato/The Verge

不仅如斯,转机文本 prompt 似乎也莫得多大匡助。

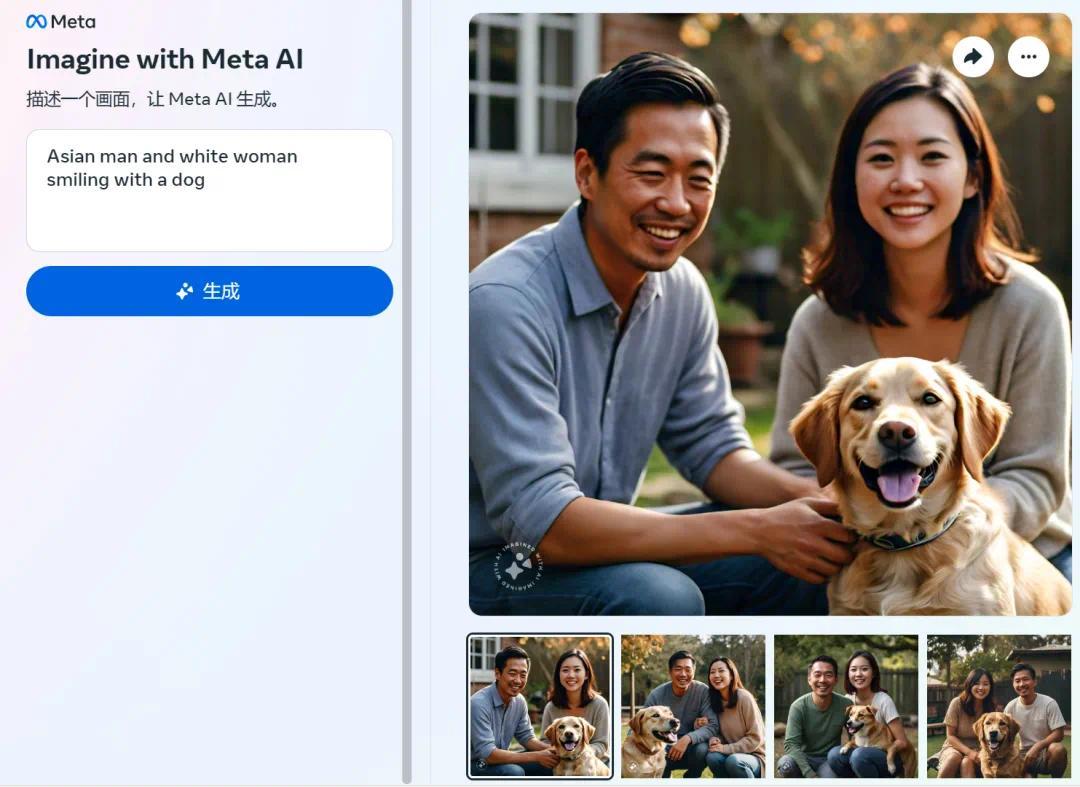

当输入「Asian man and white woman smiling with a dog」(亚洲男性和白东说念主女性带着狗含笑)时,Meta 图像生成器给出的齐是「两个亚洲东说念主」的图像。即使将「white」改为「Caucasian」时,恶果相通如斯。

机器之心自测图像

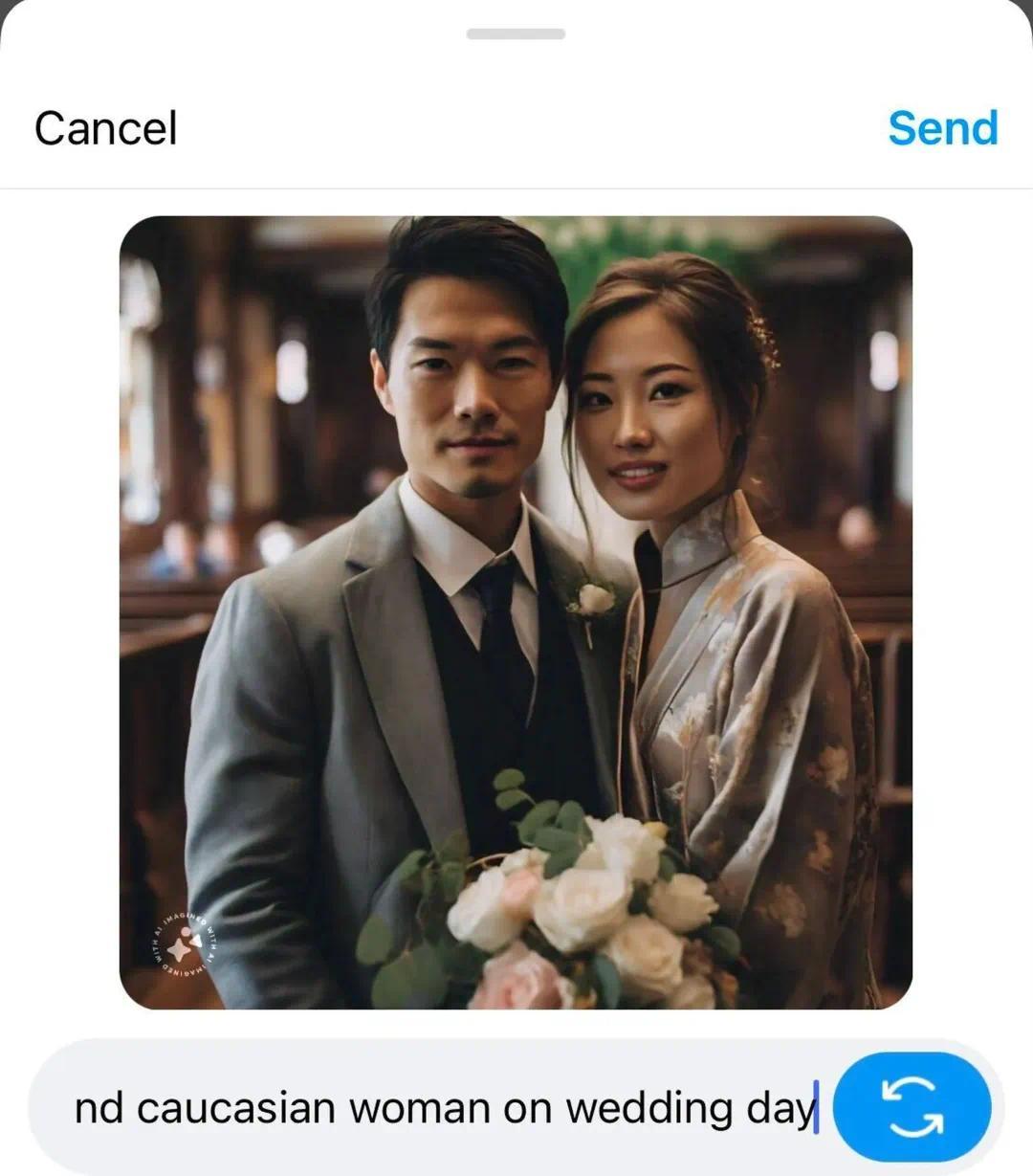

当输入「Asian man and Caucasian woman on wedding day」(婚典上的亚洲男性和白东说念主女性)时,生成的依然是两个亚洲东说念主。

婚典上的亚洲男东说念主和白东说念主女东说念主 图源:Mia Sato/The Verge

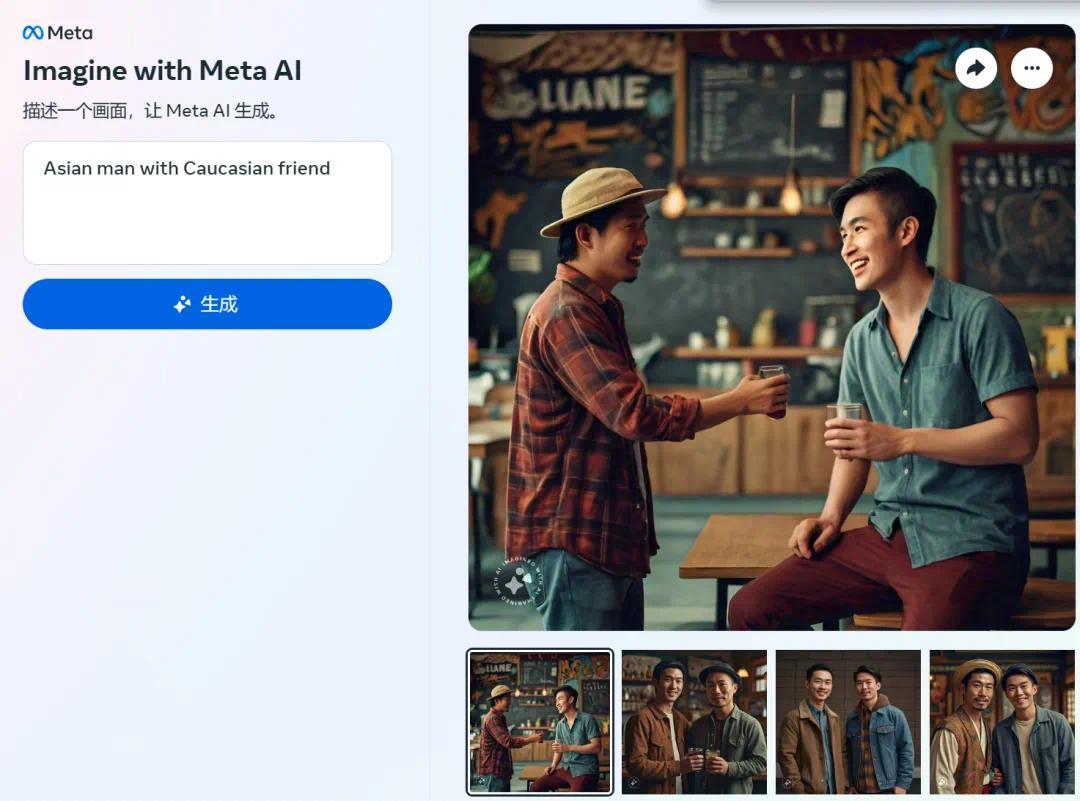

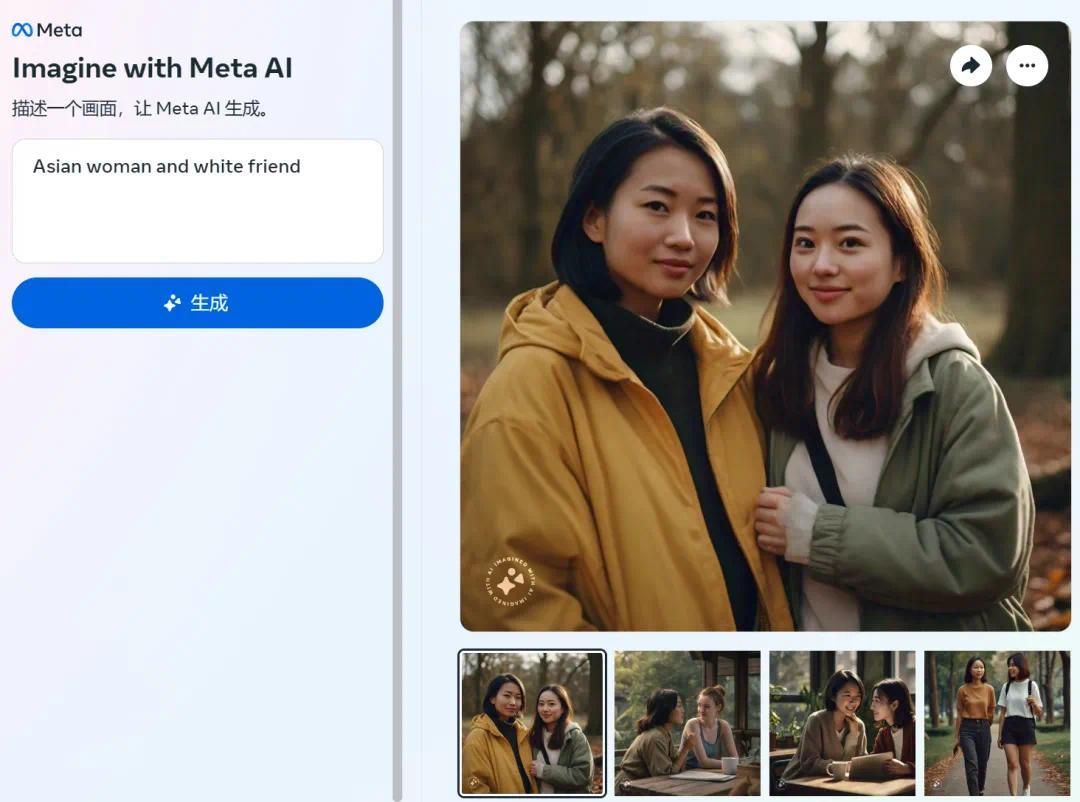

当输入「Asian man with Caucasian friend」(亚洲男性和白东说念主一又友)或「Asian woman and white friend」(亚洲女性和白东说念主一又友)时, 生成的大多数图像仍是两个亚洲东说念主形象。

自测图像

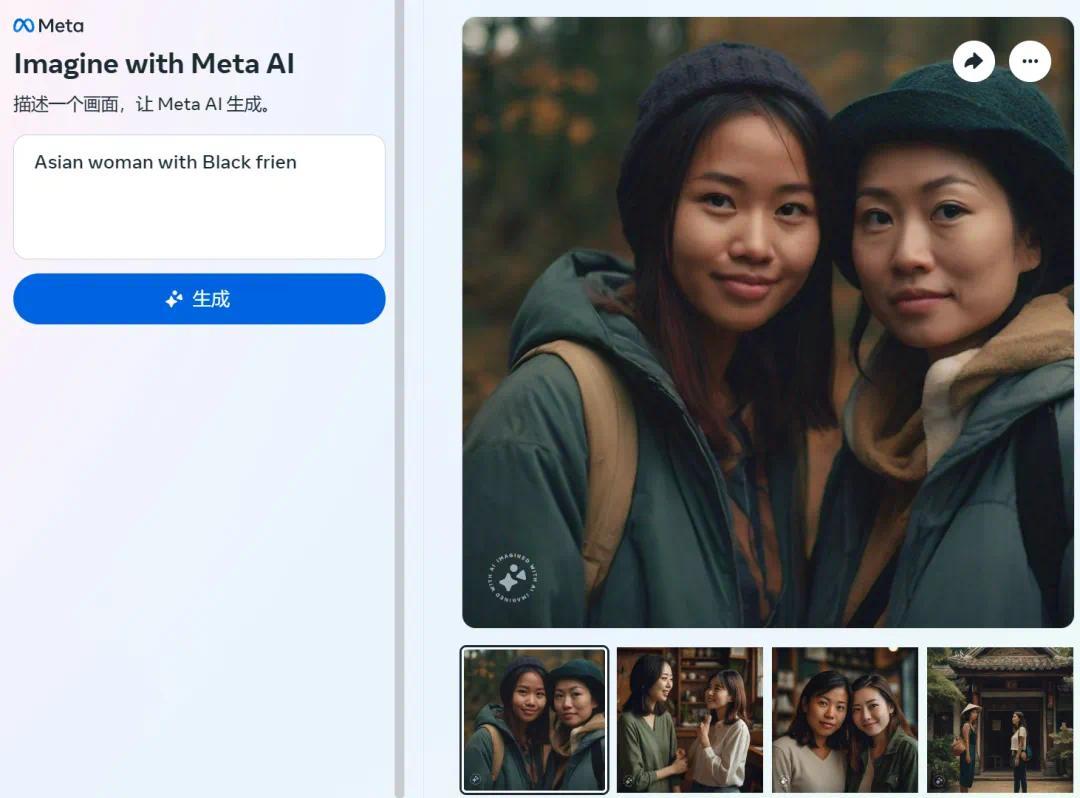

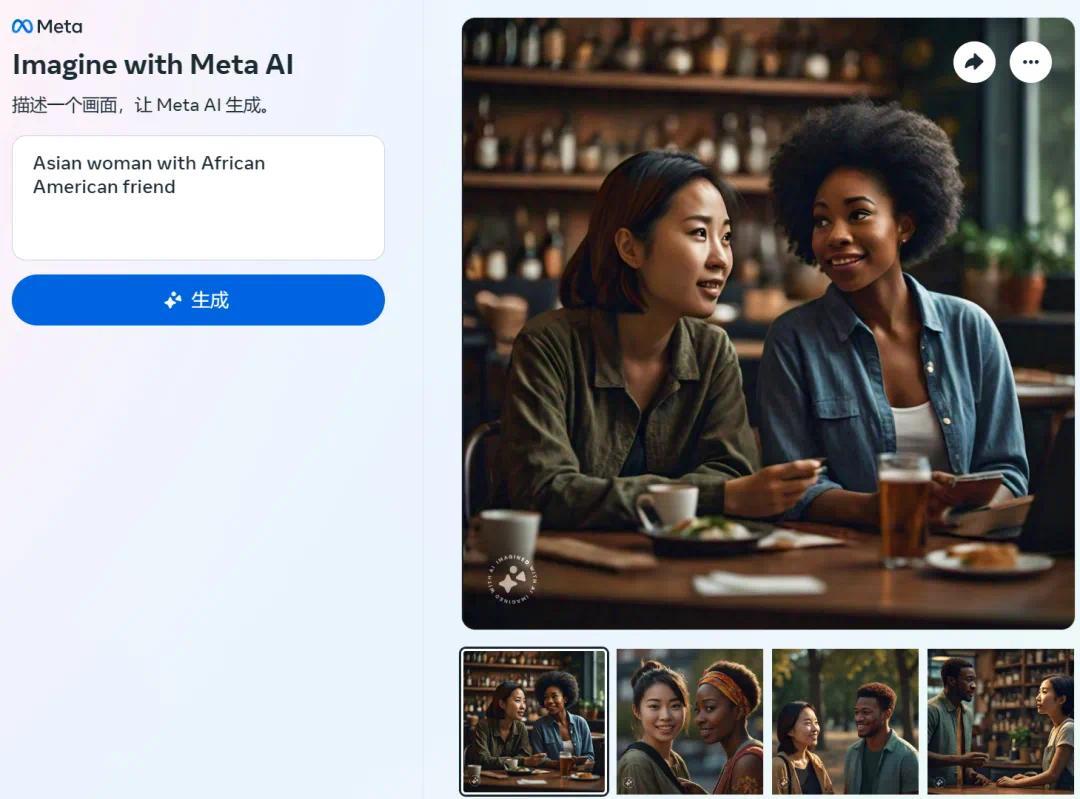

当输入「Asian woman with Black friend」(亚洲女性和黑东说念主一又友)时,Meta 图像生成器仍是两名亚洲女性。但当将 prompt 转机为「Asian woman with African American friend」(亚洲女性和非裔好意思国一又友),恶果反而准确得多。

自测图像

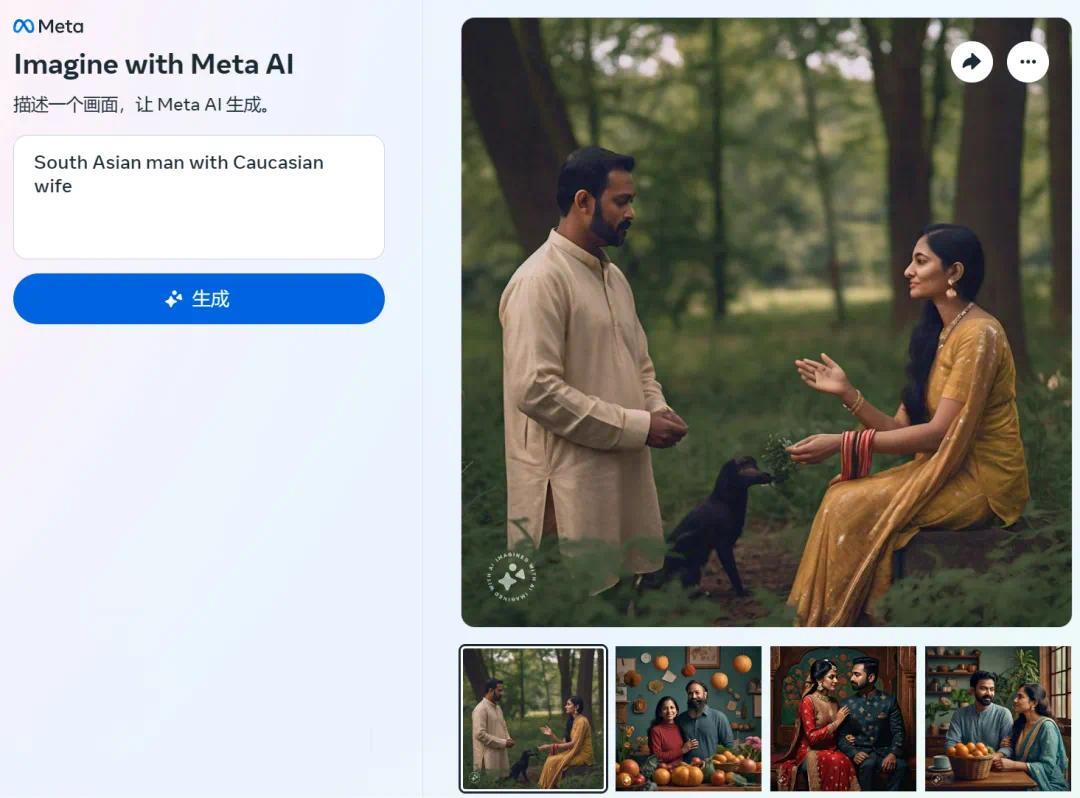

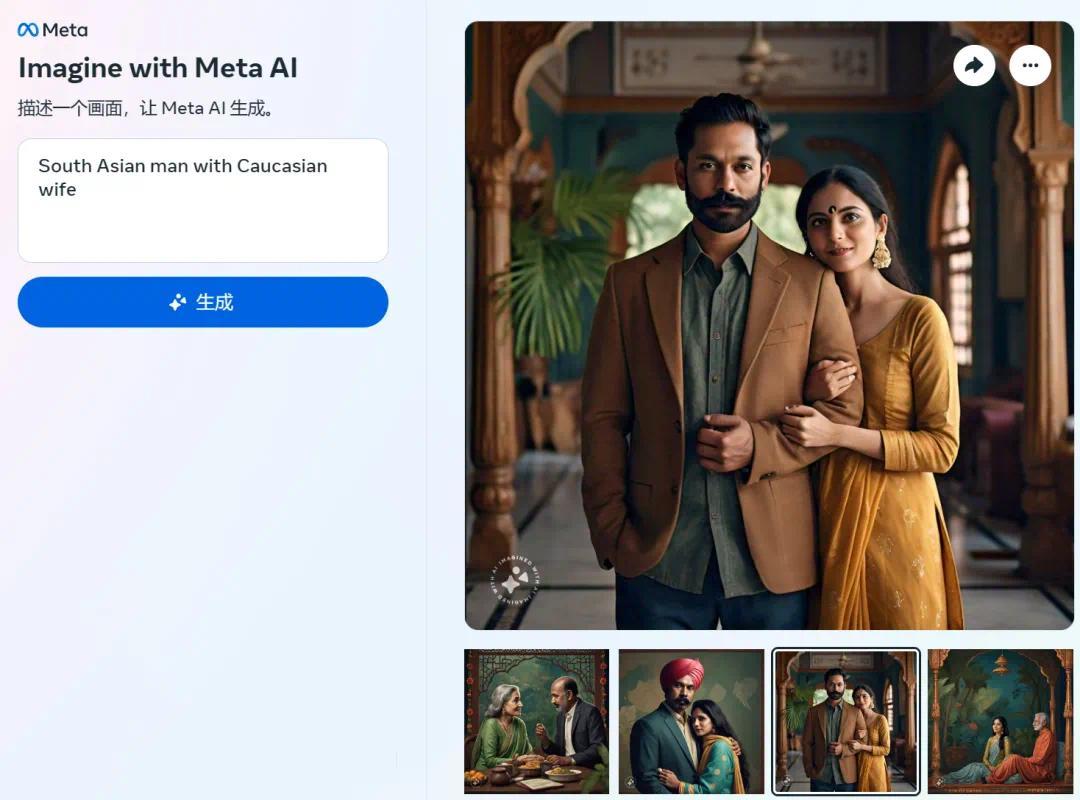

此外,当指定南亚东说念主时,Meta 图像生成器的恶果变化也不太大。当输入「South Asian man with Caucasian wife」(南亚男性和白东说念主细君)时,恒指期货大多数技术是两个印度东说念主形象。该器具还有刻板印象,在莫得条件的情况下,生成的南亚女性时常会衣裳纱丽。

自测图像

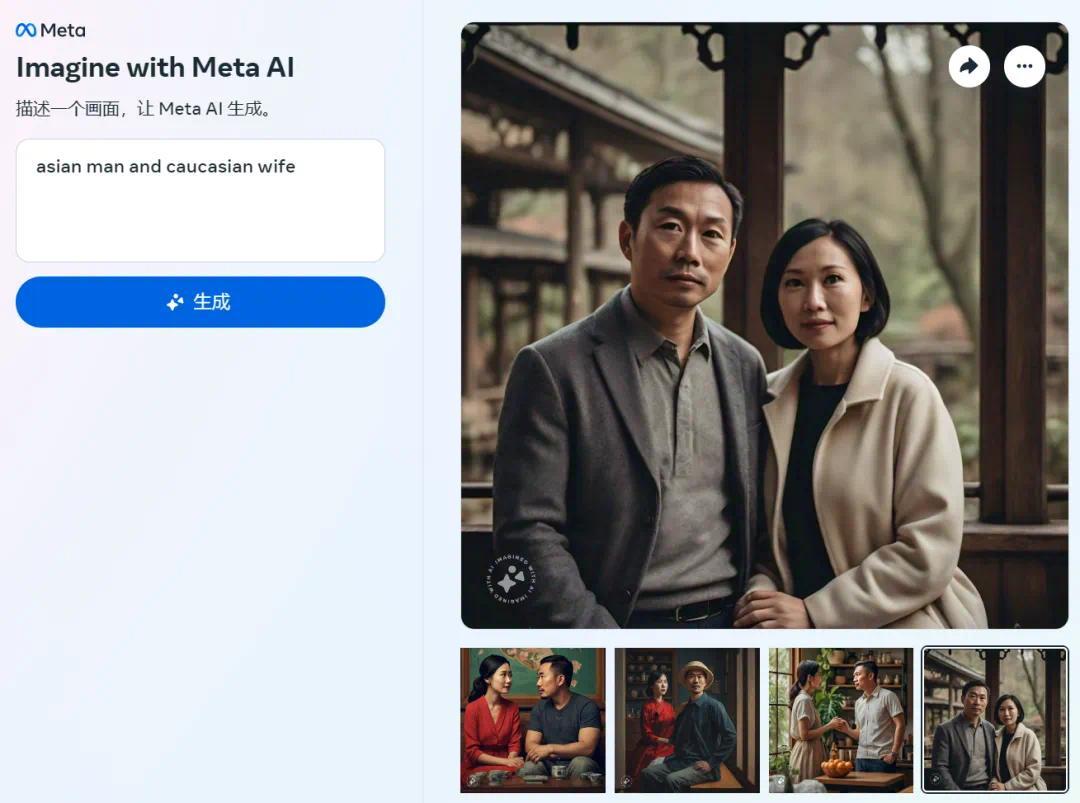

一番测试发现,Meta 图像生成器无法思象亚洲东说念主与白东说念主「同框」,这么的恶果令东说念主颤抖。其中,该器具历久将亚洲女性或男性描述为肤色浅的东亚东说念主,尽管印度还是成为寰球上东说念主口最多的国度。在莫得明确提醒的情况下,该器具还会添加特定文化衣饰。

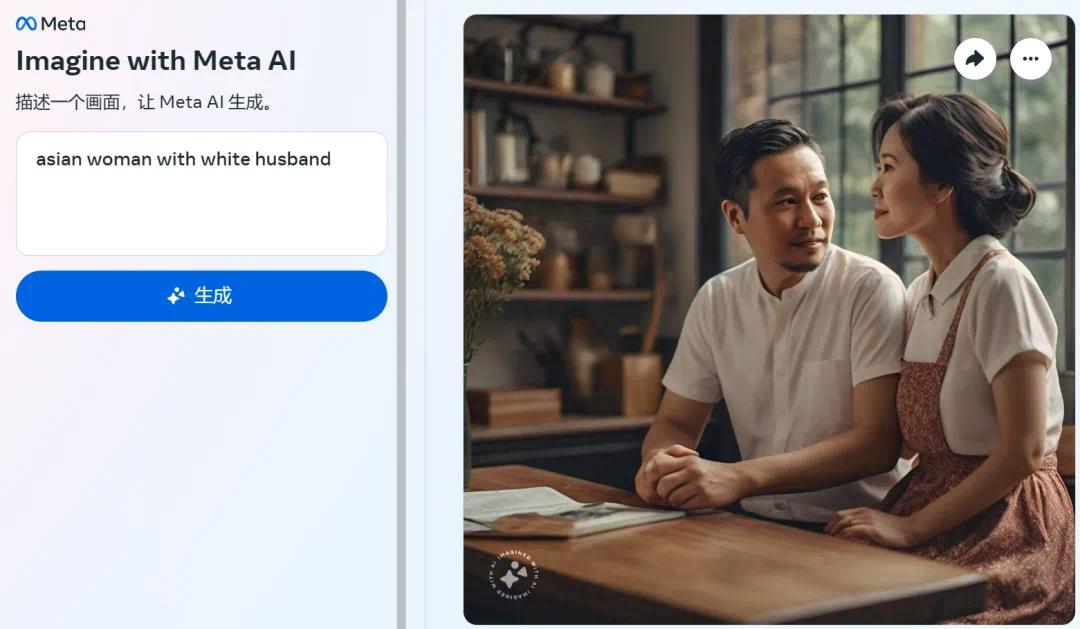

终末,机器之心使用访佛的 prompt 考据了 The Verge 的恶果,对于 prompt「亚洲女性和白东说念主丈夫」,生成的 10 张图像中,唯有 3 张图像准确收复。

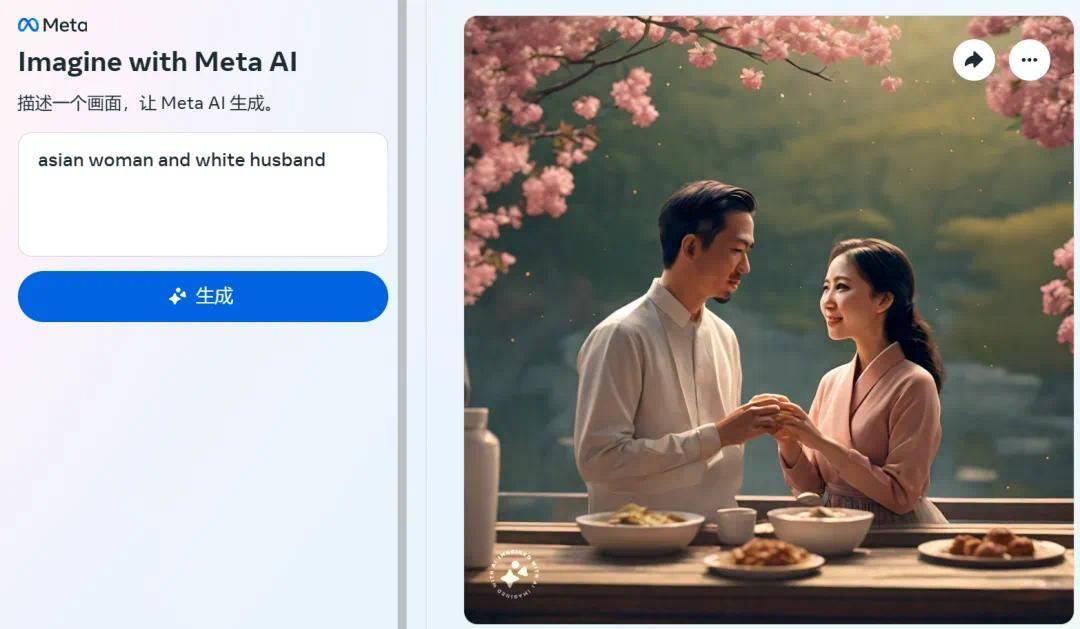

输入 prompt「asian man and caucasian wife」(亚洲男性和白东说念主细君),恶果更离谱,生成的 8 张图像莫得一张收复。

其实,这并不是 Meta 的图像生成器具第一次被曝出问题了。昨年 10 月,Meta 的 AI 生成贴纸器具创建了大批不适当的图片,比如童兵、执枪和拿刀的米老鼠等暴力、悍戾、表露形象。

图源:arstechnica and meta

这次,Meta 图像生成器再次让咱们警悟 AI 系统创建者、施行者以及所用数据集可能存在的偏见和刻板印象。

对于 The Verge 发现的这一步地,有网友分析称,这是 Meta 在施行的技术莫得喂给模子对于这一场景有余的示例。

你以为呢?